Ollama实现AI本地部署

Ollama实现AI本地部署

RainSilenlyDeepSeek最近太火了,主要它是开源的可以本地部署,本着爱折腾的精神就自己本地部署了一下。但是实际使用下来,想要更好的性能还是用DeepSeek官方的在线服务更好。也可能我电脑不行

先说一下我的笔记本电脑配置

CPU:i5-11300H

GPU:MX450 2G显存

内存:16G

真就办公本

一、安装Ollama

1.打开Ollama官网,选择合适的版本下载,也可以点这里直接下载win版。

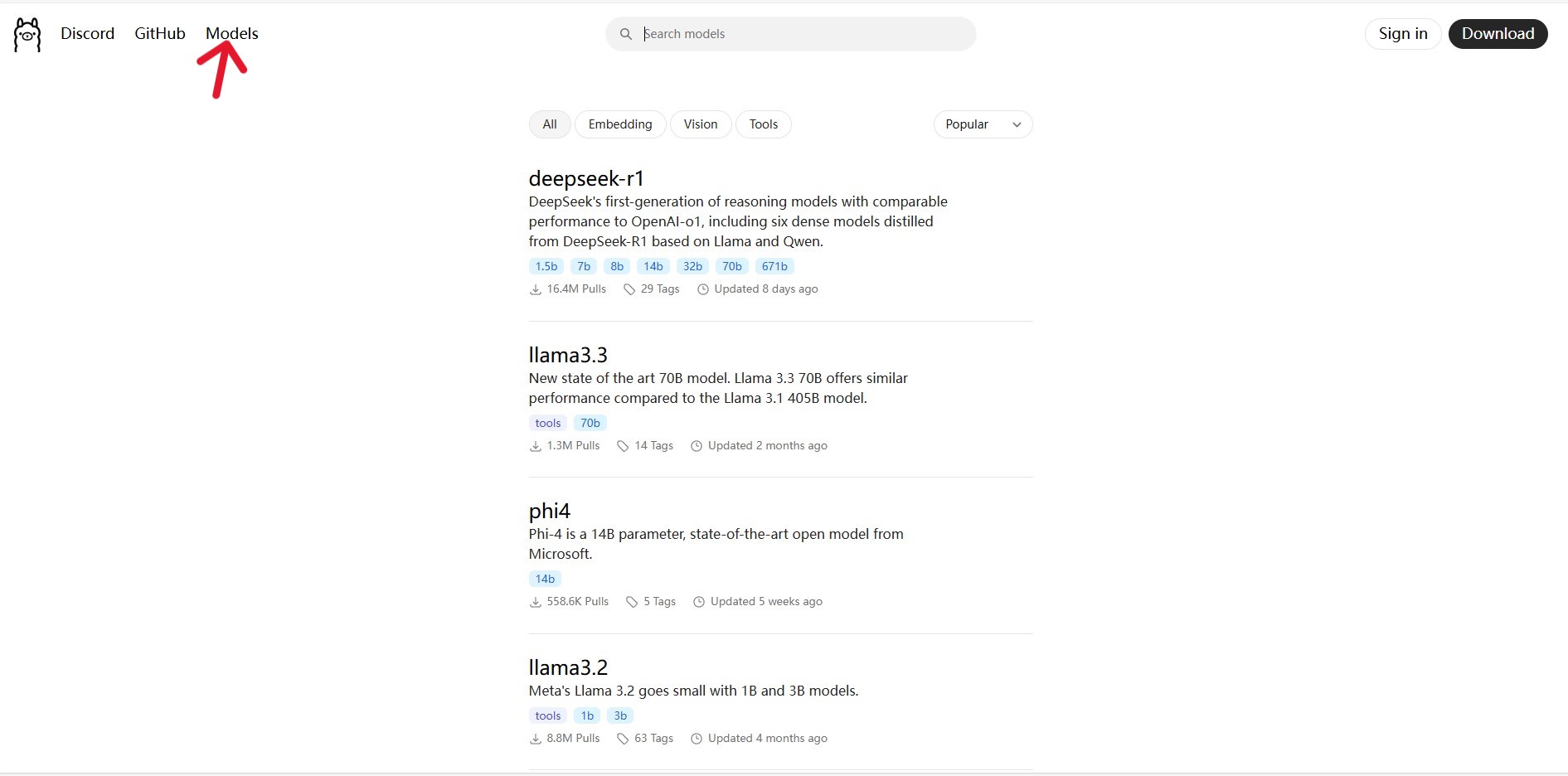

2.点击主页面的Models可以看到包括DeepSeek在内的很多开源大模型,如:llama等。

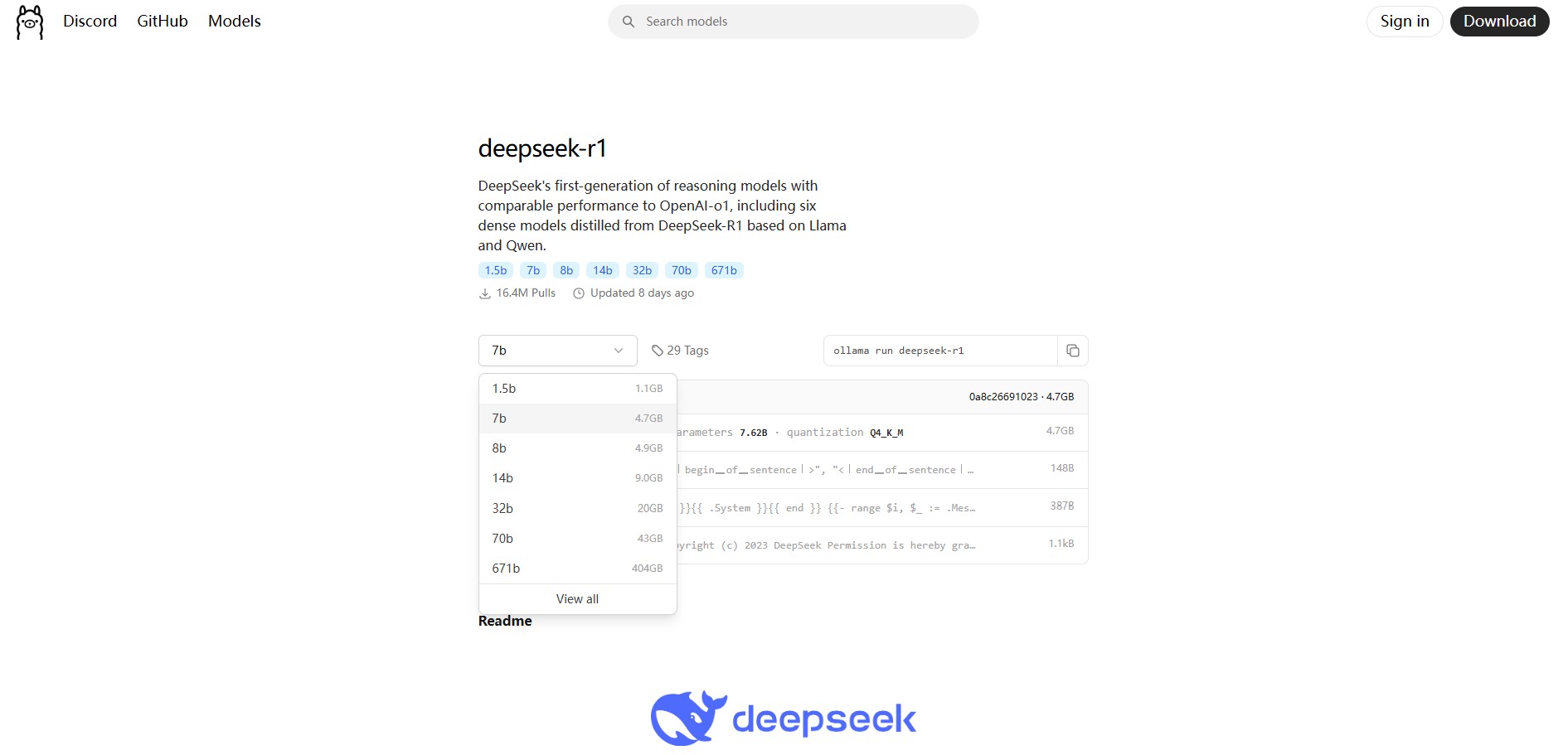

3.我们选DeepSeek,进去后可以看到有很多版本,这里解释一下“b”是“billion”的意思即“十亿”,1.5b就是该模型参数量为15亿。参数越多AI回答的越好,但内存、显存占用也会变多。

我先试了一下1.5b回答只有几句话且很多驴头不对马嘴,所以推荐安装8b版本。

4.默认安装在C盘!默认安装在C盘!默认安装在C盘!建议转移安装位置。

- 以管理员运行cmd,先输入 “d:” 进入D盘。

- 输入 setx OLLAMA_MODELS d:\ollama\models /M —— 改变系统环境变量

- 输入 cd ollama —— 进入Ollama目录

- 输入 OllamaSetup.exe /dir=d:\ollama —— 指定安装位置

- 弹出安装界面,默认安装即可。

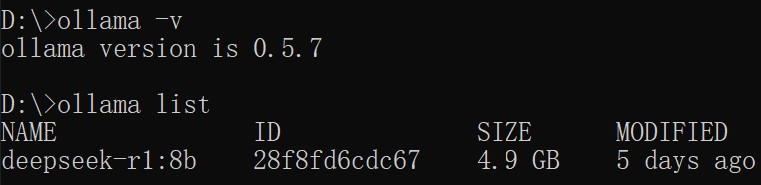

重新打开cmd,输入 ollama -v,显示ollama version is xxx表明安装成功!后续可以输入 ollama list查看安装的AI大模型有哪些。

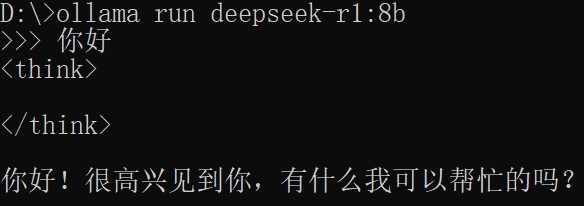

5.在cmd中输入第三步中复制的命令(ollama run deepseek-r1:8b),如果卡住可以按ctrl+c再重新下载,会继续上次进度。

6.下好之后,仍然输入第三步复制的代码(这个代码相当于有就运行,没有就下载),成功返回提示信息到此DeepSeek成功本地部署,开始感受本地AI的乐趣吧!退出输入/bye即可。